spring boot

vga

Pull APP

产品经理

Toast提示信息

图像阴影检测

控制算法

java项目实战

按键

数字签名伪造漏洞

基于范围的for循环

手机浏览器

heartbeating

cisp考试难度

filter

系统架构师

atf

IO-Link

TestStand

数据库增删改查

可解释性

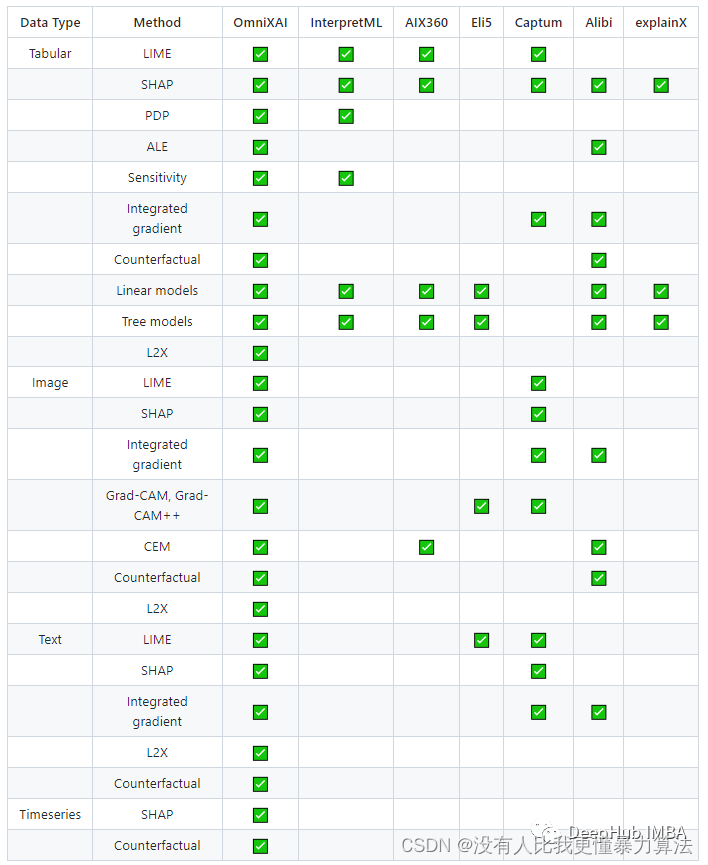

2024/4/21 5:47:276个机器学习可解释性框架

1、SHAP

SHapley Additive explanation (SHAP)是一种解释任何机器学习模型输出的博弈论方法。它利用博弈论中的经典Shapley值及其相关扩展将最优信贷分配与局部解释联系起来.

举例:基于随机森林模型的心脏病患者预测分类

数据集中每个特征对模型预测的贡献由Shap…

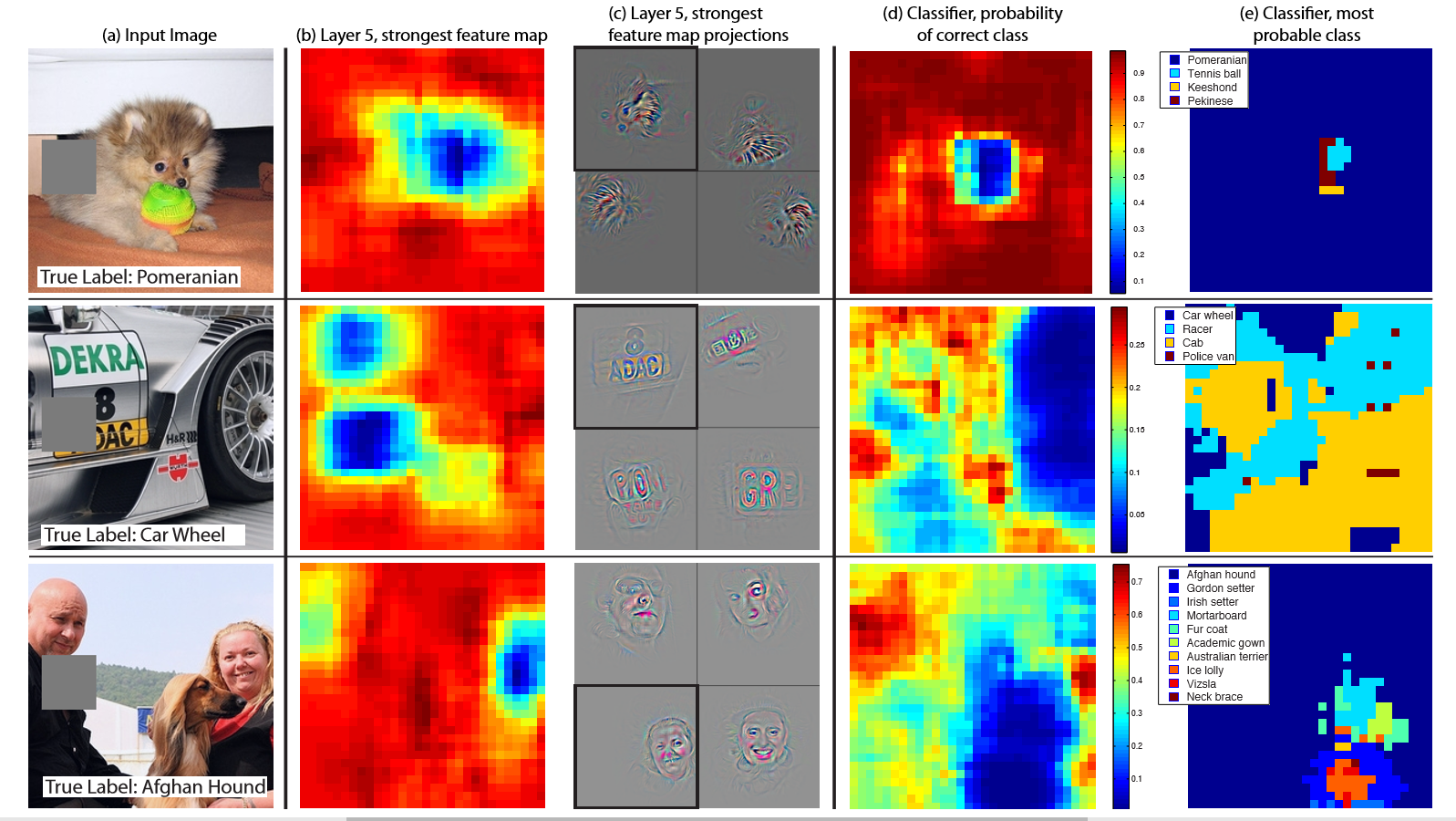

Visualizing and Understanding Convolutional Networks阅读笔记

Visualizing and Understanding Convolutional Networks阅读笔记 摘要1. 前言 [ 1 ] ^{[1]} [1]2. 使用反卷积网络可视化3. 卷积网络可视化 [ 2 ] ^{[2]} [2]3.1 特征可视化3.2 训练过程中特征的演化3.3 特征不变性3.4 架构选择3.5 遮挡敏感性 参考文章 摘要 CNN模型已经取得了…

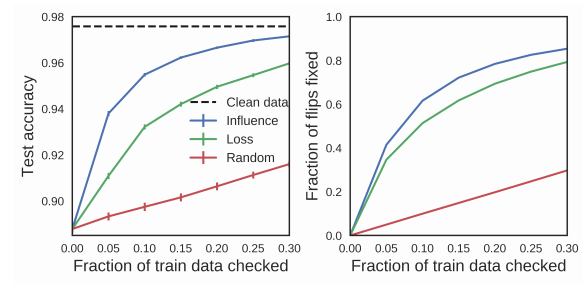

Understanding Black-box Predictions via Influence Functions阅读笔记

Understanding Black-box Predictions via Influence Functions阅读笔记 1.案例1----理解模型行为2.案例2----生成对抗训练样本3.案例3----调试域不匹配4.案例4----修正错误标注参考 1.案例1----理解模型行为 通过告诉我们对一个给定的预测“负责”的训练点,影响函数…

【博士每天一篇文献-实验】Is a Modular Architecture Enough?

阅读时间:2023-11-26

1 介绍

年份:2022 作者:Sarthak Mittal,Yoshua Bengio,蒙特利尔大学 期刊: Advances in Neural Information Processing Systems 引用量:22 这篇论文探讨了模块化架构在机…

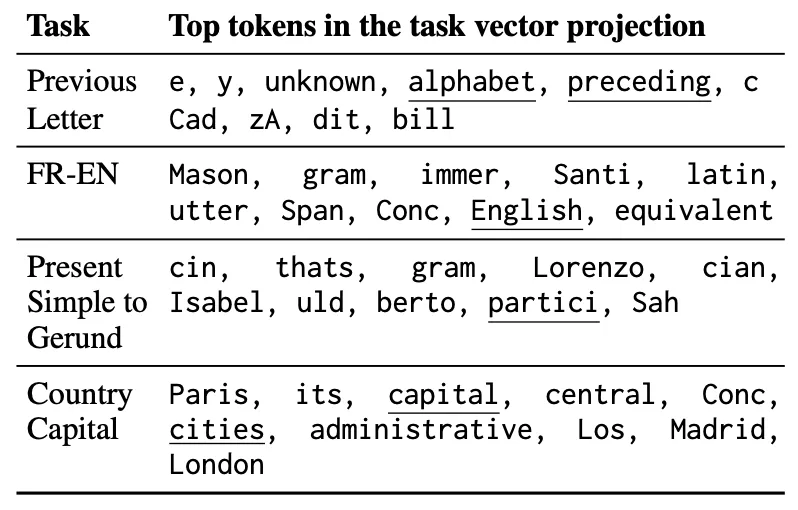

EMNLP 2023 | DeepMind提出大模型In-Context Learning的可解释理论框架

论文题目:In-Context Learning Creates Task Vectors 论文链接:https://arxiv.org/abs/2310.15916 01. 引言 此外,作者也提到本文的方法与软提示(soft-prompt)[1]方法类似,soft-prompt也是通过调整大模型内…

使用LIME解释各种机器学习模型代码示例

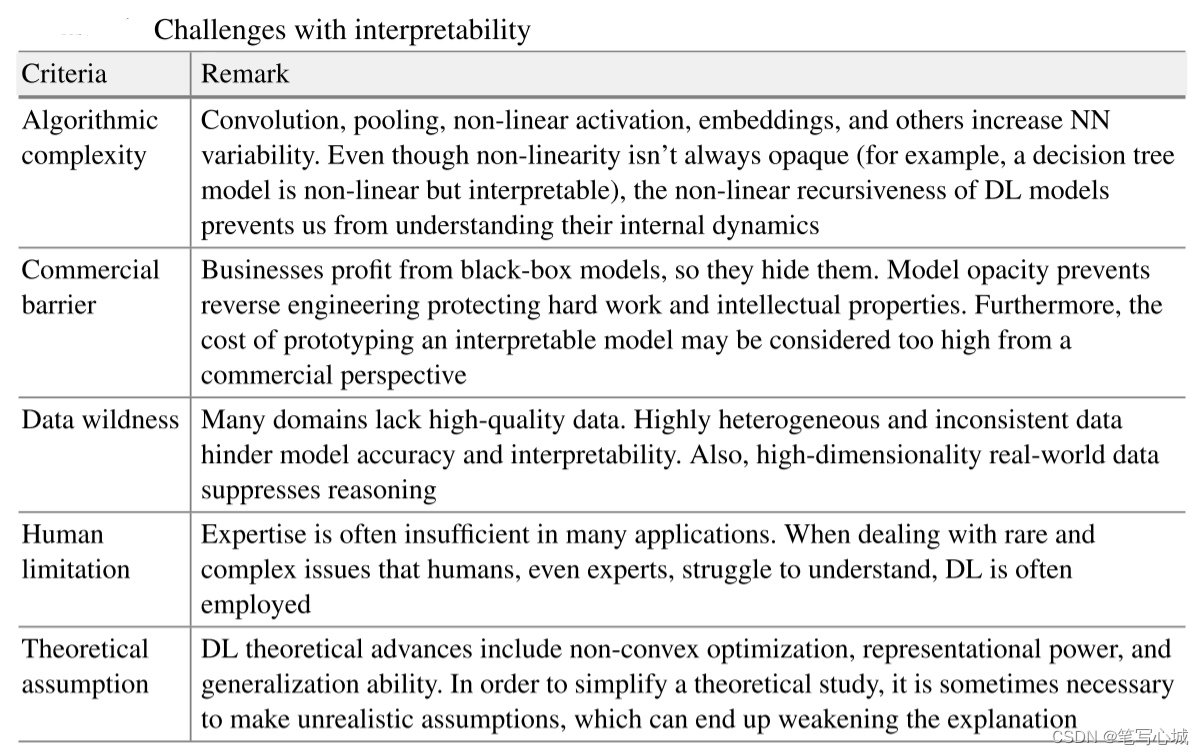

机器学习模型变得越来越复杂和准确,但它们的不透明性仍然是一个重大挑战。理解为什么一个模型会做出特定的预测,对于建立信任和确保它按照预期行事至关重要。在本文中,我们将介绍LIME,并使用它来解释各种常见的模型。

LIME

LIME…